Improvisación visual y sonora + piezas audio-reactivas

José Miguel Luna, junto a los participantes del laboratorio Conectividades: El sonido e imagen como medios artísticos de inmersión, como evento de socialización de sus resultados realizaron una sesión de improvisación sonora en vivo con visuales audio-reactivas en el domo del Planetario de Bogotá el pasado 15 de julio.

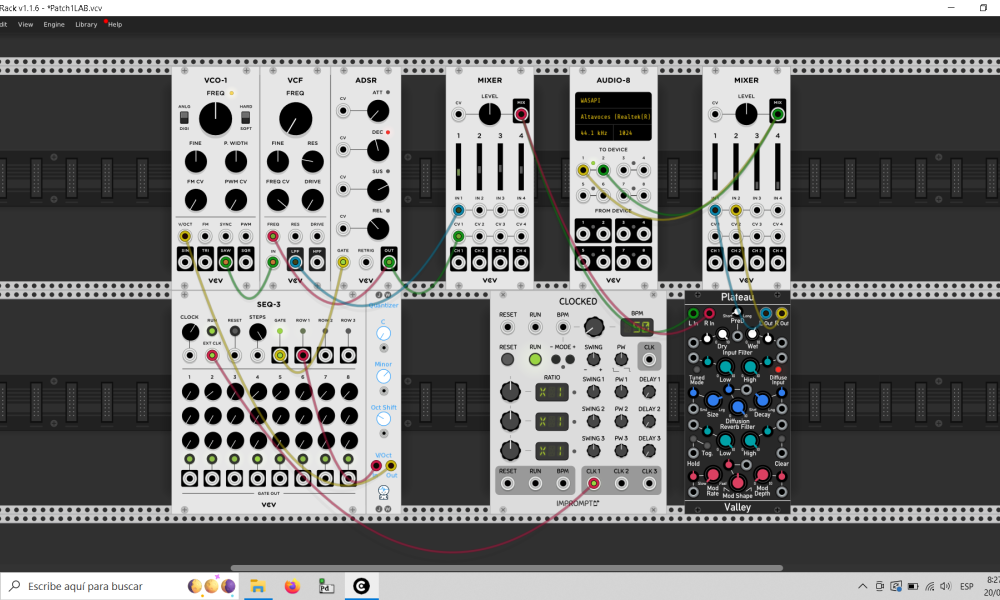

Los participantes utilizaron instrumentos musicales digitales conectados a dispositivos hardware para ser interpretados como instrumentos físicos y lograr interacciones sonoras y visuales. Trabajaron con lenguajes de programación por objetos, módulos, con protocolos de comunicación MIDI y OSC, así como con los programas TouchDesigner, VCV Rack, Supercollider y Pura Data.

“Las personas que nos inscribimos tenemos un perfil sonoro principalmente, aunque tenemos la necesidad de descubrir la imagen. Sobre todo, necesitábamos encontrar otras formas narrativas, algo que nos permitió explorar el programa TouchDesigner”, expone Sonia Poveda, una de las participantes.

Captura de pantalla de proyecto en TouchDesigner

Mediante este programa, el laboratorio pudo construir imágenes y darles movimiento a partir de la relación que se crea dentro del mismo software y conectar otros programas, para posibilitar una experiencia entre lo sonoro y lo visual.

Otro de los formatos por medio de los cuales se documentó todo el proceso y los resultados de cada uno de los participantes es la página web, que muestra el desarrollo del laboratorio y en la que se pueden consultar y descargar las notas de bitácora, las galerías y las piezas sonoras y audiovisuales presentados en el concierto.

Adicionalmente, también se podrá encontrar un repositorio GitHub, donde están algunos ejemplos de proyectos que utilizaron VCV Rack y TouchDesigner. Estos proyectos, o parches de código, son ejercicios que se desarrollaron durante las sesiones y que hacen parte de la composición final.

Captura de pantalla de un proyecto en VCV Rack

Estos fueron los procesos y algunos aspectos resaltados de cada uno de los participantes del laboratorio.

Ana María Cárdenas

Su instrumento partió de un oscilador (VCO-1) básico que genera ondas a diferentes frecuencias, así como un filtro de control de frecuencias (VCF) y un controlador de ADSR para ajustar la duración del sonido. Utilizó un efecto de reverberación y un secuenciador Darius para dar variaciones inesperadas a la secuencia de notas, bajo la idea de una secuencia algorítmica generativa.

Ana González

Creó la serie de videos Pquyquy sue, Disonancia Cognitiva Chibby aʒhɣ y describe su proyecto como “distintos MIDI y pájarxs que, en un aparato celular, pasan forzosamente por otro artefacto que los reproduce, hasta llegar a un control de sonido que queda a la espera de la disonancia cognitiva, comunicación, lenguaje, palabra, signos, arbitrarios, hipoacusia”.

Mauro Patiño

Su desarrolló se titula eq3 y consiste en cuatro secuenciadores, “cada uno aterrizado por un quantizer y avivados por el pulso de un reloj que los mantiene latiendo”, explica Patiño, creativo digital, narrador oral y participante de procesos de cocreación transmedia. “De salida, mixers independientes que llevan la señal limpia de los canales y la señal intervenida por sutiles efectos de reverb y delay. Una máquina hecha para un tímido queriendo armonizar con otros outputs”, añade.

Hugo Trujillo

Para Trujillo, en el laboratorio “todo partió de un proceso de experimentación en torno a lo sonoro-orgánico desde el código de programación, particularmente desde un software dedicado a la síntesis de audio y la composición algorítmica de Supercollider”.

Mediante este programa, los participantes pudieron alterar la frecuencia, la ganancia y la amplitud del sonido. “Se juega, se experimenta y se transita por sonidos que, si bien llegan a ser ruido, no pierden la magia de ser generados por sencillas órdenes entregadas al computador”, expresa.

Francisco Arango

Durante el laboratorio, Arango creó un parche, o sonido obtenido de un sintetizador, que comunica los programas Ableton Live y VCV Rack, mediante la función de bridge, que envía información MIDI desde Ableton hasta VCV.

Santiago Gil

El patch –parche– desarrollado por Gil, consistió en tres osciladores conectados, cada uno a un cuantizador y a un secuenciador con el objetivo de crear un autómata capaz de reproducir distintas escalas en un rango de frecuencias distinto, pero siempre respetando una tonalidad. Durante este proceso decantó elementos hasta llegar al sonido de un solo oscilador a una velocidad de reloj muy lenta –entre 30 y 50 bpm–. Así mismo, este secuenciador reproduce frecuencias muy graves con envolventes cortas, permitiendo simular un pulso constante que a pesar de ser poco variable.

Como componente abierto al público el laboratorio realizó un encuentro sonoro y una charla, que se pueden revisitar.

El encuentro Improvisación libre desde la síntesis modular e instrumentos analógicos, a cargo de Diego Serrano Cadena, abordó posibilidades creativas y posibles rutas para el trabajo sonoro y el lenguaje de improvisación.

Y la charla a cargo Gustavo Román, doctor en Experimental Music & Digital Media, titulada; UX design en proyectos y experiencias multimedia, acercó a los participantes a diversas nociones sobre lo interdisciplinar, la virtualidad, la computación, la hiperconectividad y lo transmedialidad.